class="topic_img" alt=""/>

class="topic_img" alt=""/>

哈佛商业评论称数据科学家是 21 世纪最性感的工作。所以,对于那些 ML 刚刚开始的人来说,这篇博客机器学习算法工程师需要知道的十大算法是非常有用的。

ML 算法是可以从数据中学习并从中改进的算法,无需人工干预。学习任务可能包括将输入映射到输出,在未标记的数据中学习隐藏的结构,或者“基于实例的学习”,其中通过将新实例与来自存储在存储器中的训练数据的实例进行比较来为新实例生成类标签。

1. ML 算法的类型

有三种 ML 算法:

1. 监督学习:

监督学习可以理解为:使用标记的训练数据来学习从输入变量(X)到输出变量(Y)的映射函数。

Y = f(X)

监督学习问题可以有两种类型:

分类:预测输出变量处于类别形式的给定样本的结果。例如男性和女性,病态和健康等标签。

回归:预测给定样本的输出变量的实值结果。例子包括表示降雨量和人的身高的实值标签。

在这篇博客中介绍的前 5 个算法——线性回归,Logistic 回归,CART,朴素贝叶斯,KNN 都是监督学习。

人工智能领域的大牛吴恩达曾在他的公开课中提到,目前机器学习带来的经济价值全部来自监督学习。

2. 无监督学习:

无监督学习问题只有输入变量(X),但没有相应的输出变量。它使用无标签的训练数据来模拟数据的基本结构。

无监督学习问题可以有两种类型:

1.关联:发现数据集合中的相关数据共现的概率。它广泛用于市场篮子分析。例如:如果顾客购买面包,他有 80% 的可能购买鸡蛋。

2.群集:对样本进行分组,使得同一个群集内的对象彼此之间的关系比另一个群集中的对象更为相似。

3.维度降低:维度降低意味着减少数据集的变量数量,同时确保重要的信息仍然传达。可以使用特征提取方法和特征选择方法来完成维度降低。特征选择选择原始变量的一个子集。特征提取执行从高维空间到低维空间的数据转换。例如:PCA 算法是一种特征提取方法。

Apriori,K-means,PCA 是无监督学习的例子。

3. 强化学习:

强化学习是一种机器学习算法,它允许代理根据当前状态决定最佳的下一个动作。

强化算法通常通过反复试验来学习最佳行为。它们通常用于机器人的训练,机器人可以通过在碰到障碍物后接收负面反馈来学习避免碰撞。近期的 alphago zero 就是采用的强化学习的方法,来完成实验的。

监督学习算法

1.线性回归

在 ML 中,我们有一组输入变量(x)用于确定输出变量(y)。输入变量和输出变量之间存在某种关系,ML 的目标是量化这种关系。

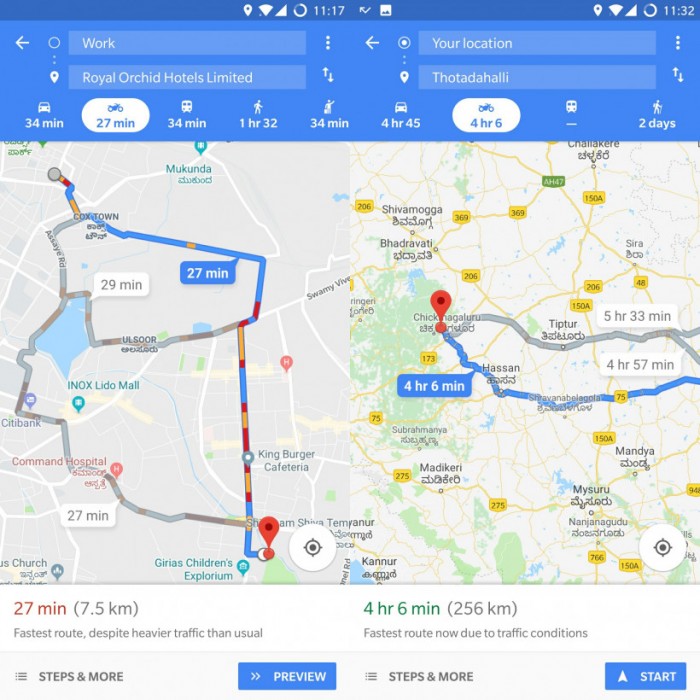

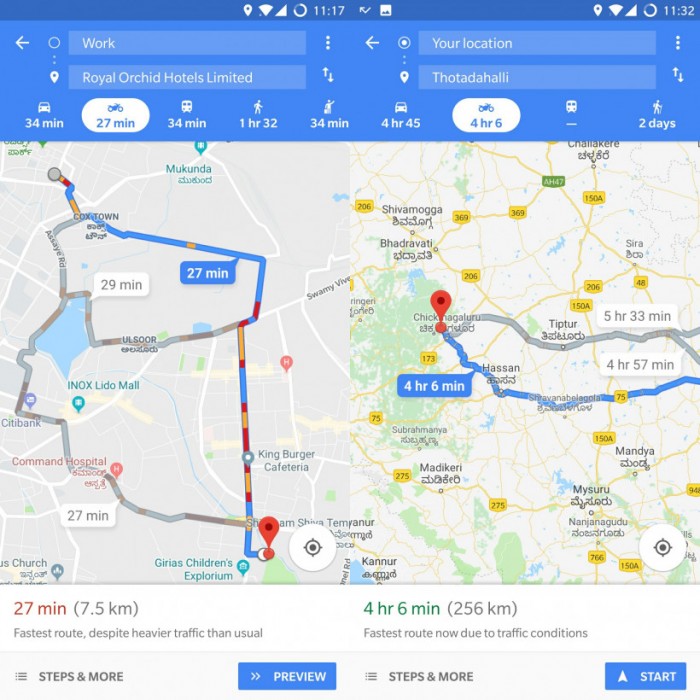

图一

在线性回归中,输入变量(x)和输出变量(y)之间的关系表示为形式为 y = ax + b 的方程。因此,线性回归的目标是找出系数a和b的值。这里,a是截距,b是线的斜率。

图 1 显示了数据集的绘制x和y值。目标是拟合最接近大部分点的线。

2. Logistic 回归

逻辑回归最适合二进制分类(y = 0 或 1 的数据集,其中 1 表示默认类)例如:在预测事件是否发生时,发生的事件被分类为1。在预测人会生病或不生病,生病的实例记为1)。它是以其中使用的变换函数命名的,称为逻辑函数h(x)= 1 /(1 + e ^ x),它是一个S形曲线。

在逻辑回归中,输出是以缺省类别的概率形式出现的。因为这是一个概率,所以输出在0——1 的范围内。输出(y值)通过对数转换x值,使用对数函数h(x)= 1 /(1 + e ^ -x)来生成。然后应用一个阈值来强制这个概率进入二元分类。

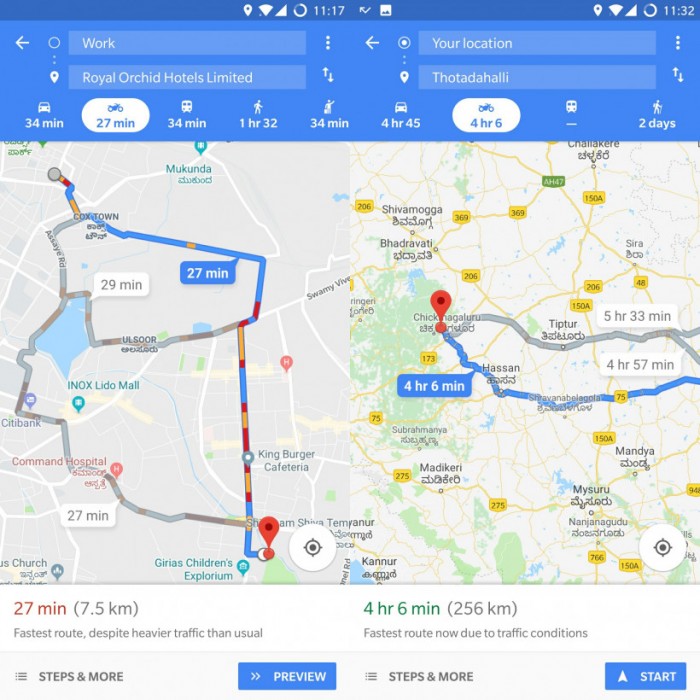

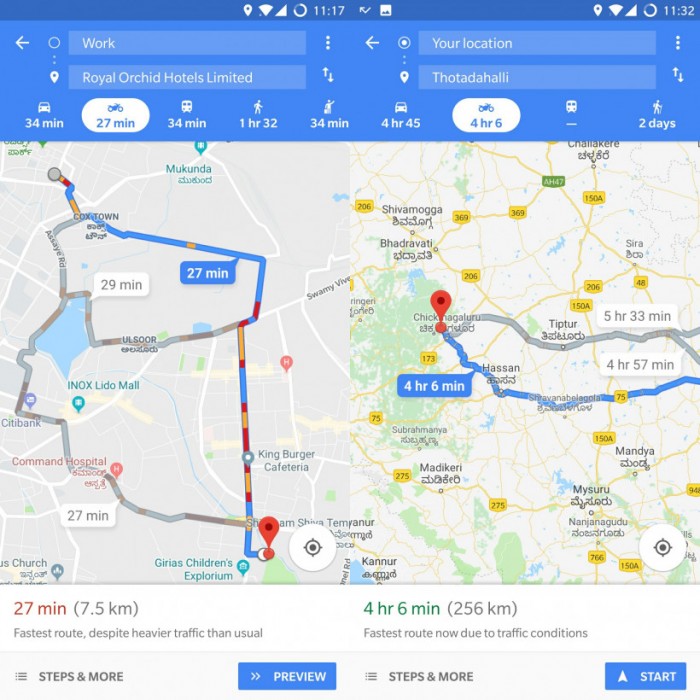

图二

在图 2 中,为了确定肿瘤是否是恶性的,默认变量是 y = 1(肿瘤=恶性);x变量可以是肿瘤的量度,例如肿瘤的大小。如图所示,逻辑函数将数据集的各种实例的x值转换成 0 到 1 的范围。如果概率超过阈值 0.5(由水平线示出),则将肿瘤分类如恶性。

逻辑回归的目标是使用训练数据来找到系数 b0 和 b1 的值,以使预测结果与实际结果之间的误差最小化。这些系数是使用最大似然估计技术估计的。

3. CART

分类和回归树(CART)是决策树的一个实现方式。

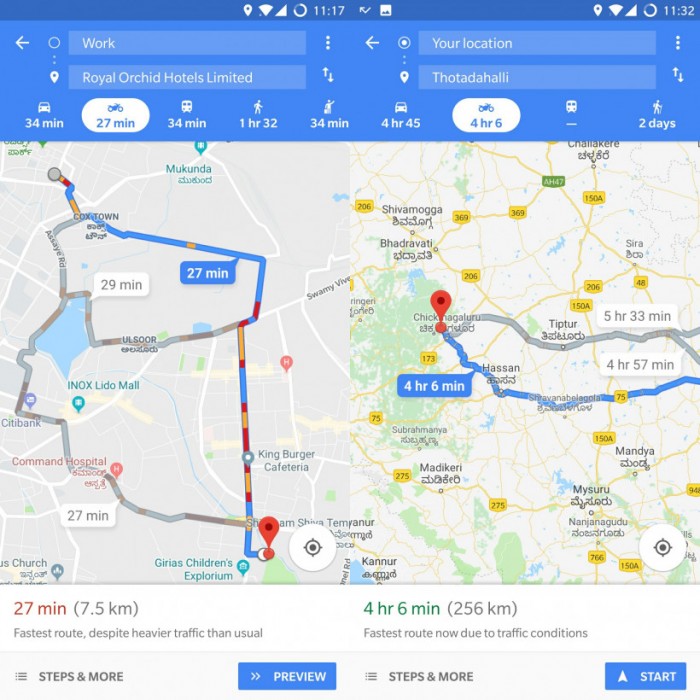

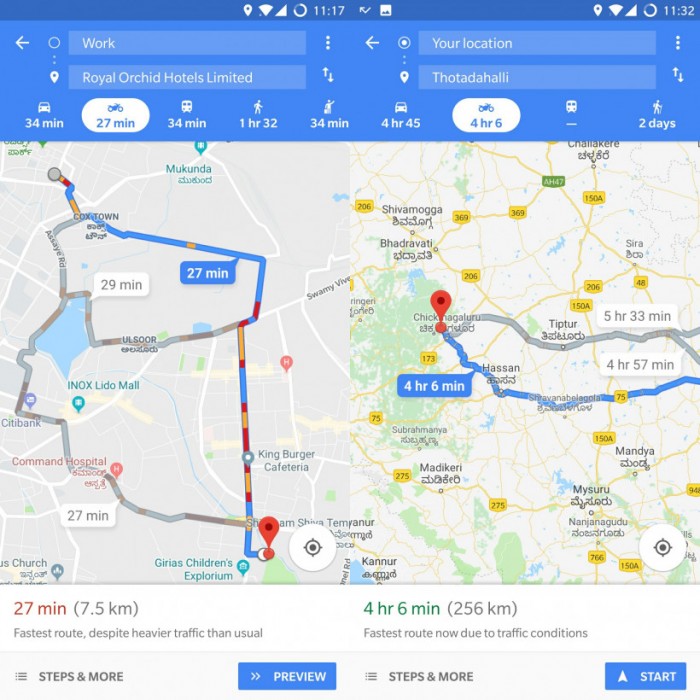

非终端节点是根节点和内部节点,终端节点是叶节点。每个非终端节点表示单个输入变量(x), 叶节点表示输出变量(y)。该模型用于做出如下预测:遍历树的分裂到达一个叶节点,并输出叶节点上存在的值。

图 3 中的决策树根据年龄和婚姻状况分类是否购买跑车或小型货车。如果这个人 30 多年没有结婚,我们可以如下预测:“30 多年? - >是 - >'已婚? - >不。因此,该模型输出一个跑车。

图三

4. 朴素贝叶斯

为了计算事件发生的概率,假设已经发生了另一个事件,我们使用贝叶斯定理。为了计算给定某个变量值的结果的概率,也就是说,根据我们的先验知识(d)计算假设(h)为真的概率,我们使用贝叶斯定理如下:

P(h d)=(P(d h)* P(h))/ P(d)

· P(h d)=后验概率。

· P(d h)=可能性。数据d的概率假设h是真的。

· P(h)=类别先验概率。假设h的可能性为真(不考虑数据)。

· P(d)=预测值先验概率。数据的可能性(与假设无关)。

图四

以图 4 为例,如果天气=“阳光”,结果如何?

为了确定结果 play ='yes'或'no',给定变量 weather ='sunny'的值,计算P(是 sunny)和P(no sunny),并选择结果的概率较高。

P(是晴天)=(P(晴天是)* P(是))/ P(晴天)

=(3/9 * 9/14)/(5/14)

= 0.60

P(no sunny)=(P(晴天)* P(no))/ P(晴天)

=(2/5 * 5/14)/(5/14)

= 0.40

因此,如果天气=“晴天”,结果是 play ='是'。

5. KNN

K 邻近算法使用整个数据集作为训练集,而不是将数据集分成训练集和测试集。

当新的数据实例需要结果时,KNN 算法遍历整个数据集,以找到新实例的k个最近的实例,或者与新记录最相似的k个实例,然后对于分类问题的结果(对于回归问题)或模式输出均值。

实例之间的相似度使用欧几里德距离和 Hamming 距离等度量来计算。

无监督学习算法:

6. Apriori

Apriori 算法用于事务数据库挖掘,然后生成关联规则。它在市场篮子分析中被广泛使用,在这个分析中,检查数据库中经常出现的产品组合。一般来说,我们写出如果一个人购买项目X,然后他购买项目Y的关联规则为:X - > Y。

例如:如果一个人购买牛奶和糖,那么他很可能会购买咖啡粉。这可以写成关联规则的形式:{牛奶,糖} - >咖啡粉。

7. K-means

K-means 是一种迭代算法,将相似的数据分组到簇中。计算k个簇的质心,并将一个数据点分配给质心和数据点之间距离最小的簇。

步骤1:k-means 初始化:

a)选择k的值。在这里,让我们取 k = 3。

b)将每个数据点随机分配到 3 个群集中的任何一个。

c)为每个集群计算集群质心。红色,蓝色和绿色星星表示 3 个星团中的每一个的质心。

步骤2:将每个观察结果与群集相关联:

将每个点重新分配到最近的集群质心。这里,上面的 5 个点被分配到具有蓝色质心的簇。按照相同的步骤将点分配给包含红色和绿色质心的群集。

第 3 步:重新计算质心:

计算新簇的质心。旧的质心由灰色星星表示,而新的质心是红色,绿色和蓝色星星。

第 4 步:迭代,然后退出,如果不变。

重复步骤2-3,直到没有从一个群集切换到另一个群集。一旦连续两个步骤没有切??换,退出k-means 算法。

8. PCA

主成分分析(PCA)用于通过减少变量的数量来使数据易于探索和可视化。这是通过将数据中的最大方差捕获到一个称为“主要成分”的轴上的新的坐标系来完成的。每个组件是原始变量的线性组合,并且彼此正交。组件之间的正交性表明这些组件之间的相关性为零。

第一个主成分捕捉数据中最大变化的方向。第二个主要组件捕获数据中的剩余变量,但变量与第一个组件不相关。

9. 随机森林装袋

随机森林是对袋装决策树(bagged decision trees)改进。

装袋(Bagging):装袋的第一步是创建多个模型,使用 Bootstrap Sampling 方法创建数据集。在 Bootstrap Sampling 中,每个生成的训练集由来自原始数据集的随机子样本组成。这些训练集中的每一个与原始数据集大小相同,但有些记录会重复多次,有些记录根本不会出现。然后,整个原始数据集被用作测试集。因此,如果原始数据集的大小为N,那么每个生成的训练集的大小也是N,测试集的大小也是N。

装袋的第二步是在不同的生成的训练集上使用相同的算法创建多个模型。在这种情况下,让我们讨论随机森林。与决策树不同的是,每个节点被分割成最小化误差的最佳特征,在随机森林中,我们选择随机选择的特征来构建最佳分割。在每个分割点处要搜索的特征的数量被指定为随机森林算法的参数。

因此,在用随机森林装袋时,每棵树都是使用记录的随机样本构建的,每个分叉是使用预测变量的随机样本构建的。

10. Boosting with AdaBoost

套袋(Bagging)是一个平行的集合,因为每个模型都是独立建立的。另一方面,boosting 是一个连续的集合,每个模型的建立是基于纠正前一个模型的错误分类。

Adaboost 代表 Adaptive Boosting。

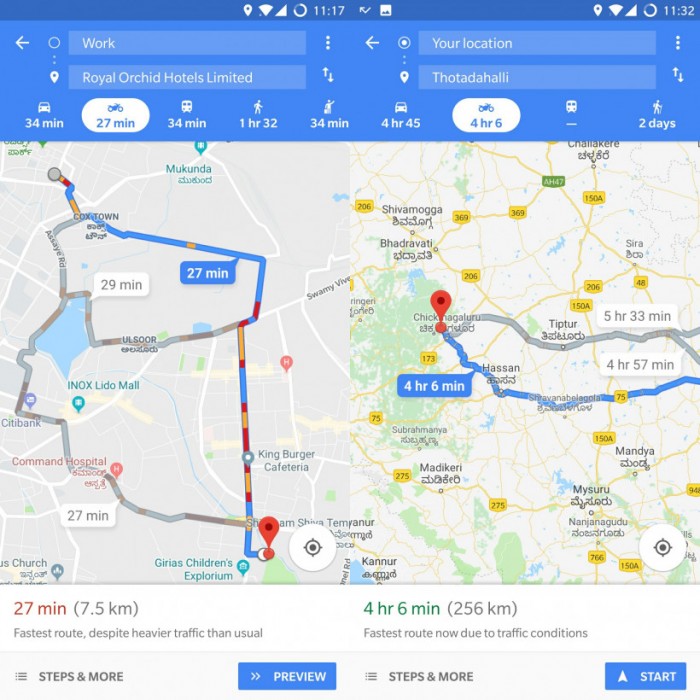

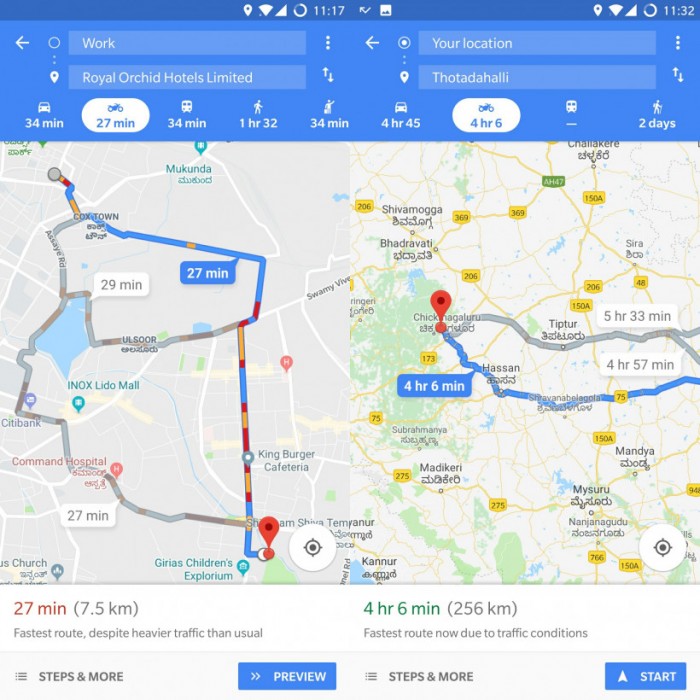

图9

在图 9 中,步骤1,2,3 涉及一个称为决策残缺的弱学习者(一个 1 级决策树,仅基于 1 个输入特征的值进行预测)。步骤 4 结合了以前模型的 3 个决策树(在决策树中有 3 个分裂规则)。

步骤1:从 1 个决策树开始,对 1 个输入变量做出决定:

数据点的大小表明我们已经应用相同的权重将它们分类为一个圆或三角形。决策树在上半部分产生了一条水平线来分类这些点。我们可以看到有 2 个圆圈错误地预测为三角形。因此,我们将为这两个圈子分配更高的权重,并应用另一个决策树桩。

步骤2:移动到另一个决策树,以决定另一个输入变量:

我们观察到,上一步的两个错误分类圈的大小大于其余点。现在第二个决策树会试图正确预测这两个圆。

步骤3:训练另一个决策树来决定另一个输入变量。

来自上一步的 3 个错误分类圈大于其余的数据点。现在,已经生成了一条垂直线,用于分类圆和三角形。

步骤4:合并决策树:

我们已经结合了以前 3 个模型中的分隔符,并观察到这个模型中的复杂规则与任何一个单独的弱学习者相比,正确地分类了数据点。

作者信息

Dr. Jason Brownlee 是一名机器学习从业者,学术研究人员,致力于帮助开发人员从入门到精通机器学习。

本文由北邮@爱可可-爱生活老师推荐,阿里云云栖社区组织翻译。

文章原标题《top-10-machine-learning-algorithms-beginners》

作者:Reena Shaw 译者:虎说八道

文章为简译,更为详细的内容,请查看原文